Podczas tegorocznego wydarzenia Kaspersky NEXT część najwybitniejszych w Europie ekspertów z dziedziny cyberbezpieczeństwa i sztucznej inteligencji zaprezentowała i omówiła swoje badania. Uczenie maszynowe, sztuczna inteligencja i zabezpieczanie urządzeń Internetu Rzeczy to kwestie, które między innymi zostały poruszone podczas tegorocznej edycji wydarzenia, która miało miejsce w Lizbonie, 14 października.

Sztuczna inteligencja a wiarygodność

Czy kiedykolwiek zastanawialiście się, ile decyzji podejmują dziś komputery? Lub ile z tych decyzji zostało podjętych z uwzględnieniem płci, rasy lub pochodzenia? Pewnie nawet nie zdajecie sobie sprawy z tego, ile decyzji podejmuje sztuczna inteligencja w zamian za człowieka. Kriti Sharma, założyciel firmy AI for Good, wyjaśnił, że algorytmy są wykorzystywane przez cały czas, aby podejmować decyzje odnośnie tego, kim jesteśmy i czego chcemy.

Ponadto według Kriti, aby ulepszyć sztuczną inteligencję, musimy zebrać dane o ludziach z różnych środowisk, odmiennej płci i pochodzeniu etnicznym. Obejrzyjcie jej występ na Ted Talk, w którym opowiada, dlaczego uprzedzenia ludzi mają wpływ na podejmowanie decyzji przez maszyny:

Skutki przypisania płci sztucznej inteligencji

Co ma wspólnego Alexa, Siri i Cortana? Wykorzystują damski głos i mają służyć ludziom. Czy technologia umacnia stereotypy? Było to przedmiotem dwóch paneli dyskusyjnych poświęconych płci i sztucznej inteligencji. Cyfrowi asystenci mają damskie głosy, ponieważ (jak udowodniło wiele badań)… ludzie tak wolą.

Co więc możemy zrobić, aby walczyć z nierównym podziałem płci w sztucznej inteligencji? Może powinniśmy używać neutralnego płciowo głosu? A może utworzyć płeć dla robotów i sztucznej inteligencji? Oprócz rozwiązania wspomnianego problemu należy również zadbać o różnorodność w zespole, który pracuje podczas tworzenia sztucznej inteligencji, odzwierciedlającą różnorodność użytkowników, dla których jest ona tworzona.

https://twitter.com/kaspersky/status/1183739717965230087?ref_src=twsrc%5Etfw%7Ctwcamp%5Etweetembed%7Ctwterm%5E1183739717965230087&ref_url=https%3A%2F%2Fwww.kaspersky.com%2Fblog%2Fkaspersky-next-2019%2F28979%2F

Ludzie ufają robotom bardziej niż innym ludziom

Robot społeczny to system sztucznej inteligencji, który komunikuje się z ludźmi i innymi robotami — a przez to, inaczej niż w przypadku Siri czy Cortany, jest obecny fizycznie. Tony Balpaeme, profesor robotyki pracujący na uczelni Ghent University, wyjaśnił, że czeka nas wzrost liczby problemów związanych z interakcją robotów z ludźmi, ponieważ roboty staną się bardziej rozpowszechnione.

Balpaeme opisał część eksperymentów naukowych, jakie przeprowadził ze swoim zespołem. Na przykład sprawdzili oni zdolność robotów i ludzi do uzyskiwania informacji wrażliwych (data urodzenia, adres zamieszkania, ulubiony kolor itp.), które mogą zostać wykorzystane do resetowania haseł. Ponieważ robotom ufamy bardziej niż ludziom, chętniej udostępniamy im informacje wrażliwe.

Inny eksperyment polegał na ingerencji fizycznej. Grupa osób, która miała za zadanie zabezpieczać budynek lub obszar, bez problemu wpuściła słodkiego robota. Nie ma powodu zakładać, że robot jest bezpieczny, a mimo to ludzie zakładają, że jest nieszkodliwy — bardzo użyteczna tendencja. Więcej informacji na temat robotyki społecznej i związanych z nią eksperymentów znajdziecie w serwisie Securelist.

https://twitter.com/kaspersky/status/1183683889514078209?ref_src=twsrc%5Etfw%7Ctwcamp%5Etweetembed%7Ctwterm%5E1183683889514078209&ref_url=https%3A%2F%2Fwww.kaspersky.com%2Fblog%2Fkaspersky-next-2019%2F28979%2F

Sztuczna inteligencja utworzy bardzo przekonujące falsyfikaty

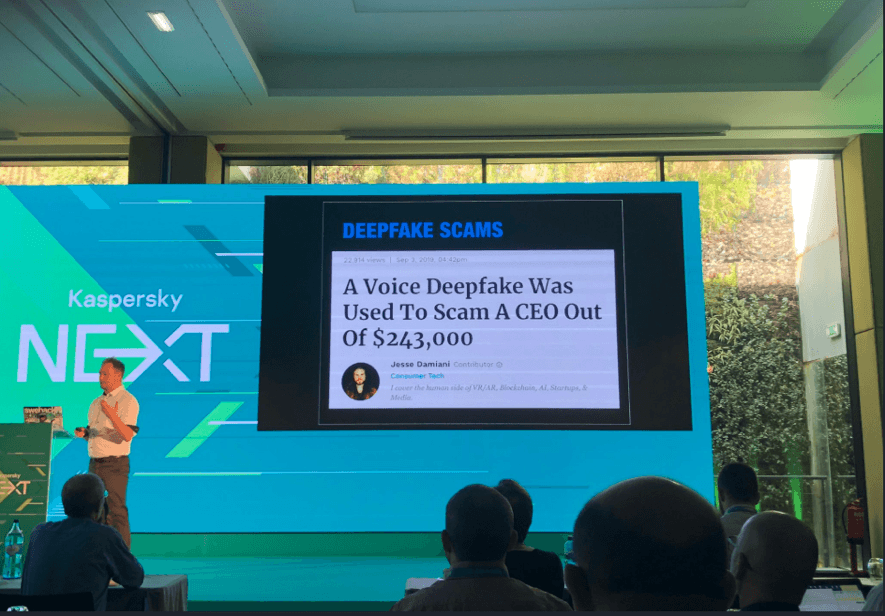

David Jacoby, członek zespołu GReAT w Kaspersky, opowiedział o socjotechnice: czatbotach, sztucznej inteligencji i zagrożeniach związanych z automatyzacją. Z biegiem czasu aplikacje służące do rozpoznawania twarzy i głosu mogą zostać wykorzystane np. w ataku socjotechnicznym.

Ponadto Jacoby mówił o podróbkach, które coraz trudniej jest wykryć. Duże obawy wzbudza to, w jaki sposób mogą one wpłynąć na przyszłe wybory i transmisje wiadomości.

Jednak największy problem stanowi zaufanie. Komu zaufacie, gdy technologia ta będzie doskonała? Według niego rozwiązaniem jest tu większa świadomość: edukacja oraz nowa technologia, która pomoże użytkownikom wykryć fałszywe filmy.

Stan bezpieczeństwa w robotyce

Dmitrij Galow, inny członek zespołu GReAT w firmie Kaspersky, opowiedział o ROS (Robot Operating System) — elastycznej platformie programistycznej służącej do tworzenia oprogramowania dla robotów. Podobnie jak wiele innych systemów, ROS nie powstał z uwzględnieniem kwestii bezpieczeństwa i w efekcie zawiera sporo błędów. Zanim produkty wykorzystujące ROS, na przykład roboty społeczne czy pojazdy autonomiczne, trafią z uniwersytetu w ręce konsumentów, ich twórcy muszą rozwiązać wspomniane problemy. Nowa wersja ROS już przechodzi gruntowne poprawki. Szerzej na ten temat mówi raport Galowa.

Używaj „prezerwatywy” do złącz USB

Marco Preuss i Dan Demeter, członkowie GReAT-a, opowiedzieli o tym, w jaki sposób ludzie chronią się przed włamaniem podczas podróży służbowych. Jak wiadomo, w hotelowym pokoju możemy napotkać ukryte kamery czy lustra dwukierunkowe.

Osobom, które mają na tym punkcie bzika, polecamy ten post opisujący porady pozwalające zwiększyć bezpieczeństwo podczas podróży autorstwa Preussa i Demetera, którzy opowiedzieli również o tym, jak ważne jest używanie „prezerwatyw” USB — tak, one istnieją naprawdę, a ich użycie przypomina te tradycyjne: jeśli macie zamiar podłączyć swój telefon do ładowania poprzez nieznany port USB, warto zabezpieczyć swoje urządzenie tym maleńkim gadżetem. Na szczęście odmiennie niż w przypadku tradycyjnych prezerwatyw można ich używać wiele razy.

Kaspersky Next

Kaspersky Next

Porady

Porady